因为发现有个域名好像收录很多

该网站共有 14,495,764 个网页被百度收录

该网站共有 14,495,770 个网页被百度收录 03-13

该网站共有 14,543,382 个网页被百度收录 03-23

该网站共有 14,578,022 个网页被百度收录 03-28

该网站共有 14,418,475 个网页被百度收录 04-07

About 508,000 results (0.22 seconds)

About 509,000 results (0.53 seconds) 03-13

About 483,000 results (0.18 seconds) 03-23 [升级改版的后遗症]

About 481,000 results (0.41 seconds) 03-28

About 477,000 results (0.50 seconds) 04-07

一直没关注过,然后问题来了

因为是非本地数据站,所以有大量的缓存开销

结果性能问题出现问题 总量大概有4000万数据

我使用的SSDB缓存,因为很久以前开发的 设置的过期时间是86400一天

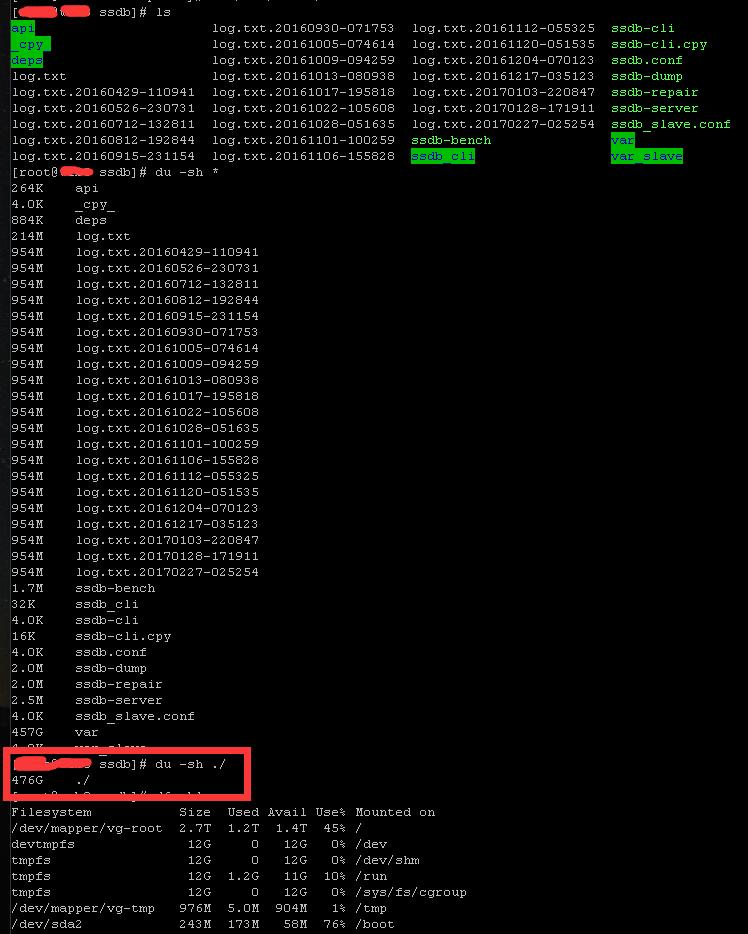

结果硬盘使用 变这个样子

是的 你没看错 SSDB缓存了457G的数据

在加上20G的日志 感觉炸了….

在加上以前写的首页缓存类失效了

现在访问首页巨卡

一狠心,决心重写

以前目录结构乱糟糟的

现在新的架构清晰了

使用 composer 来管理依赖包

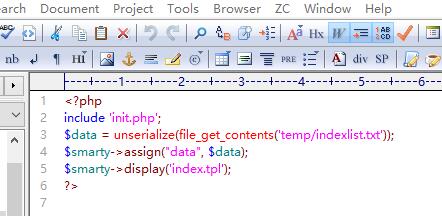

代码清晰到什么程度?

满满的这种既视感

首页原来是读取远程数据在缓存本地

现在改为 cronjob定时任务运行 每N小时读取远程数据一次 数据提取为数组以后序列化写入本地文件

首页直接读取缓存的文件 没之前的各种检查开销

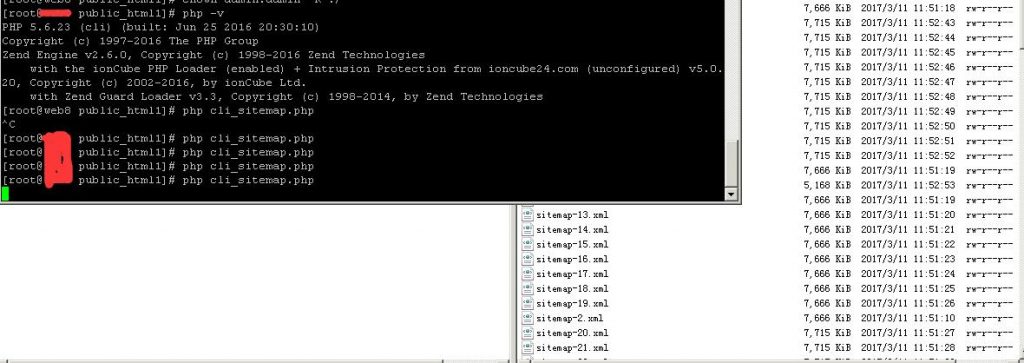

因为整个重写了 所以重新生成sitemap 的xml文件

4000万条记录 PHP循环估计也就我这么干….

生成了856个文件 每文件包含5万个url

总计占用了6.5G大小…..

40m条记录用php循环确实很刺激